Mattel presenta la prima Barbie con il diabete

Che cos’è la Big Data Analytics, spiegato con una mini-serie TV

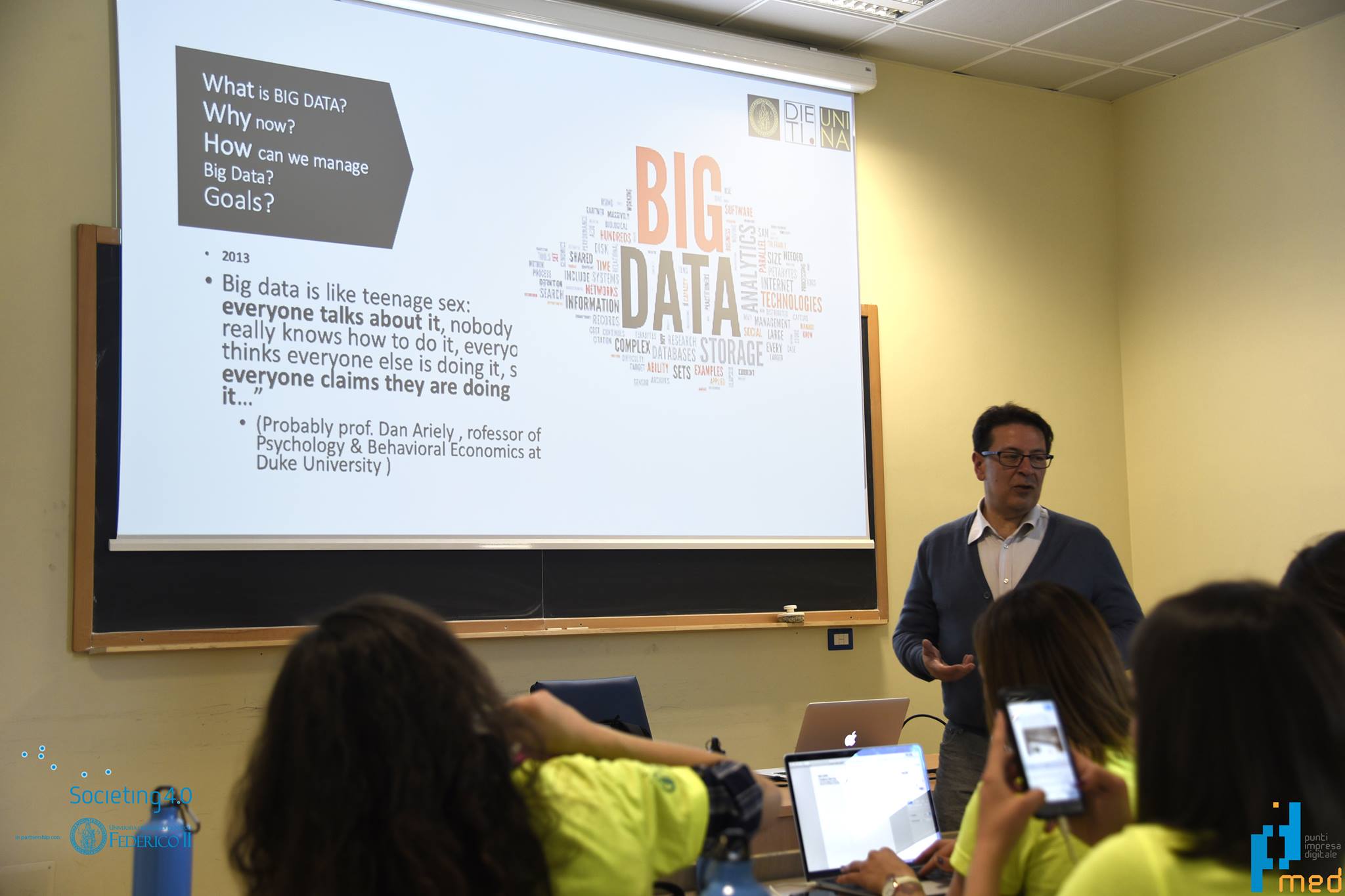

Nella nuova puntata della serie realizzata da Societing 4.0 e promossa dalla Rai, Antonio Picariello, docente di Sistemi per l’elaborazione dell’informazione, ci spiega cosa dovremmo sapere oggi sui Big Data

6 Aprile 2020

- “Societing4.0 – Che cosa sono le tecnologie 4.0″ è una miniserie per capire le principali tecnologie 4.0 (Robotica all’Intelligenza Artificiale, dalla Stampa 3D alla Realtà Aumentata/Virtuale, dai Big Data all’Internet delle cose) e per dare maggiore consapevolezza e strumenti critici sulla loro applicazione a cittadini curiosi, PMI, studenti e insegnanti.

- Per ciascuna tecnologia le telecamere dei giovani ricercatori entrano nei laboratori dell’Università Federico II dove sono studiate le tecnologie e dove sei luminari rispondono alle domande dei ragazzi ,sotto la direzione scientifica del Professore Alex Giordano.

Approfondimenti

A cura dei giovani ricercatori dell’Università degli Studi di Napoli Federico II Al giorno d’oggi, l’accesso a Internet è considerabile un bene di prima necessità e la connessione ha raggiunto livelli di quasi ubiquità su scala globale. Difatti, secondo il Global Digital Report 2019, resoconto annuale circa i comportamenti di consumo nell’ambito delle tecnologie informatiche e digitali, gli utenti Internet sono cresciuti- e crescono- a un ritmo esponenziale, dando forma ad uno scenario planetario sempre più digitale e interconnesso. Secondo il report, realizzato dalla creative agency internazionale We Are Social e dalla piattaforma di social media management Hootsuite, oggi gli utenti di Internet sono circa 4,39 miliardi, con un aumento del 9% (366 milioni) rispetto a gennaio 2018; inoltre, globalmente si registrano circa 5,11 miliardi di utenti unici di telefonia mobile, con un incremento nell’ultimo anno del 2% (vale a dire circa 100 milioni). La novità fondamentale degli ultimi anni, infatti, è la diffusione delle tecnologie digitali ed informatiche mobile (dispositivi come smartphone e tablet) e l’estensione della connettività a Internet a device fisici e di uso quotidiano, i quali vanno a formare vanno a formare il cosiddetto Internet of Things: il sistema composto da tutti i dispositivi connessi alla rete Internet che, grazie a tale connessione, possono interagire fra di loro ed essere controllati on remote. Nel mondo dunque, si registra una crescita esponenziale e continua dei dispositivi che si servono della connessione a Internet per comunicare fra di loro e con gli utenti. Tali devices connessi funzionano anche come data points: ovvero, essi sono costantemente impegnati nella produzione, nella raccolta e nella condivisione di grandi quantità di dati in formato digitale. È proprio per questo motivo che oggi si suole parlare di Big Data.

Con l’espressione big data ci si riferisce alla vasta mole di dati che viene continuamente prodotta dai devices digitali connessi. Si tratta di dati in formato digitale di natura multimediale che possono essere sia strutturati (provenienti da database) che non strutturati (non provenienti da database).

Il modello utilizzato dalla comunità scientifica internazionale per descrivere i big data è quello delle cosiddette ‘4+1 V’ : volume, variety, velocity, veracity, value (dove le prime quattro ‘v’ sono, rispetto all’ultima, di natura più strettamente tecnica).

Il termine volume (‘volume’), dunque, fa riferimento alla quantità di dati generati ogni secondo da sorgenti eterogenee: esseri umani, sensori e dispositivi mobili generano un‘enorme quantità di dati, il cui volume si espande fra il 50 e il 60% ogni anno. Secondo l’International Data Corporation nel 2020 esisteranno 40 zettabyte di dati (6 terabyte di dati per ogni persona vivente).

Con variety (‘varietà’) ci si riferisce alla grande diversità nella tipologia dei dati generati, raccolti ed utilizzati: essi infatti sono incredibilmente eterogenei fra di loro, essendo provenienti da una serie di fonti diverse, come web server, dati di borsa o dati ricavati da attività e interazioni social. In particolare la caratteristica della varietà è necessaria a sottolineare una delle principali novità dell’epoca dei big data, vale a dire il fatto che- a differenza di quanto avveniva precedentemente- oggi si prendono in considerazione anche dati semi strutturati e non strutturati, al fine di avere risultati d’analisi più accurati e profondi circa gli specifici fenomeni.

Il termine velocity (‘velocità’) fa riferimento alla rapidità con cui questi dati vengono prodotti, raccolti e trasmessi (il che, è chiaro, incide notevolmente sul volume: vale infatti la pena notare che le caratteristiche dei big data sono strettamente legate fra loro e inscindibili l’una dall’altra). La velocità, inoltre, è componente essenziale anche per la fase finale del ciclo di vita dei big data, vale a dire l’analisi: proprio per via del rapido tasso di crescita e, in generale, di cambiamento di statistiche e informazioni, è essenziale che i dati vengano raccolti e analizzati in tempo reale, al fine di non realizzare analisi i cui risultati vadano rapidamente incontro all’obsolescenza.

Con veracity (‘veridicità’) si vuole indicare la precisione e l’esattezza dei big data: considerata la quantità e la varietà dei dati prodotti e scambiati e la velocità con cui si sommano gli uni agli altri, sarebbe impensabile non prendere in considerazione la qualità delle informazioni analizzate, poiché i risultati delle analisi sempre più spesso e in maniera decisiva condizionano processi decisionali di aziende, organizzazioni e istituzioni.

Infine, l’ultima delle v è quella che rappresenta il value (letteralmente ‘valore’) legato ai big data. I big data hanno un grande potenziale in termini di generazione di vantaggio competitivo: essi producono valore poiché permettono di semplificare una serie di operazioni- o addirittura di realizzare task prima ineseguibili- attraverso l’informazione. Oggi si diffonde, infatti, l’Industrial Internet (anche detto Industry 4.0), ovvero il sottosistema dell’Internet of Things che si riferisce implementazione negli ambienti industriali con macchinari, dispositivi e software che permettono la comunicazione machine to machine (M2M, cioè fra i macchinari); human to machine (H2M, tra uomo e macchina); machine to smartphone (M2S, vale a dire tra macchina e smartphone). Così come l’IoT, di cui può essere considerato una componente, il sistema che si sviluppa con l’Industry 4.0 si basa estensivamente sulla capacità di raccogliere dati e trarre valore da questi analizzandoli: oggi si parla infatti di value of perfect information (cioè il valore dell’informazione perfetta) per indicare la capacità di ottimizzare i processi relativi alla raccolta e all’analisi dei dati, al fine di ricavare una conoscenza dei vari fenomeni osservati più immediata, approfondita e affidabile.

Con l’aumentare dei dati prodotti aumenta il loro potenziale in termini di conoscenza e, di conseguenza, aumenta il loro essere risorsa economica (ma anche sociale, politica e culturale) di primaria importanza.

Già da diversi anni- con la prima ondata della Rivoluzione Digitale, vale a dire con la prima diffusione globale di Internet- la letteratura sociologica ha introdotto la categoria temporale del Postindustriale. La principale novità di tale periodo rispetto al precedente – sulla quale si imperniano le ulteriori differenze- sarebbe proprio il fatto che il focus, prima posto sul consumo di beni e prodotti, oggi è costituito dall’informazione, la quale assurge a risorsa di sconfinata importanza e che esercita un’influenza decisiva sia nell’ambito del quotidiano che in quello dell’impresa.

È proprio per questo motivo che oggi si suole parlare di Big Data.

Con l’espressione big data ci si riferisce alla vasta mole di dati che viene continuamente prodotta dai devices digitali connessi. Si tratta di dati in formato digitale di natura multimediale che possono essere sia strutturati (provenienti da database) che non strutturati (non provenienti da database).

Il modello utilizzato dalla comunità scientifica internazionale per descrivere i big data è quello delle cosiddette ‘4+1 V’ : volume, variety, velocity, veracity, value (dove le prime quattro ‘v’ sono, rispetto all’ultima, di natura più strettamente tecnica).

Il termine volume (‘volume’), dunque, fa riferimento alla quantità di dati generati ogni secondo da sorgenti eterogenee: esseri umani, sensori e dispositivi mobili generano un‘enorme quantità di dati, il cui volume si espande fra il 50 e il 60% ogni anno. Secondo l’International Data Corporation nel 2020 esisteranno 40 zettabyte di dati (6 terabyte di dati per ogni persona vivente).

Con variety (‘varietà’) ci si riferisce alla grande diversità nella tipologia dei dati generati, raccolti ed utilizzati: essi infatti sono incredibilmente eterogenei fra di loro, essendo provenienti da una serie di fonti diverse, come web server, dati di borsa o dati ricavati da attività e interazioni social. In particolare la caratteristica della varietà è necessaria a sottolineare una delle principali novità dell’epoca dei big data, vale a dire il fatto che- a differenza di quanto avveniva precedentemente- oggi si prendono in considerazione anche dati semi strutturati e non strutturati, al fine di avere risultati d’analisi più accurati e profondi circa gli specifici fenomeni.

Il termine velocity (‘velocità’) fa riferimento alla rapidità con cui questi dati vengono prodotti, raccolti e trasmessi (il che, è chiaro, incide notevolmente sul volume: vale infatti la pena notare che le caratteristiche dei big data sono strettamente legate fra loro e inscindibili l’una dall’altra). La velocità, inoltre, è componente essenziale anche per la fase finale del ciclo di vita dei big data, vale a dire l’analisi: proprio per via del rapido tasso di crescita e, in generale, di cambiamento di statistiche e informazioni, è essenziale che i dati vengano raccolti e analizzati in tempo reale, al fine di non realizzare analisi i cui risultati vadano rapidamente incontro all’obsolescenza.

Con veracity (‘veridicità’) si vuole indicare la precisione e l’esattezza dei big data: considerata la quantità e la varietà dei dati prodotti e scambiati e la velocità con cui si sommano gli uni agli altri, sarebbe impensabile non prendere in considerazione la qualità delle informazioni analizzate, poiché i risultati delle analisi sempre più spesso e in maniera decisiva condizionano processi decisionali di aziende, organizzazioni e istituzioni.

Infine, l’ultima delle v è quella che rappresenta il value (letteralmente ‘valore’) legato ai big data. I big data hanno un grande potenziale in termini di generazione di vantaggio competitivo: essi producono valore poiché permettono di semplificare una serie di operazioni- o addirittura di realizzare task prima ineseguibili- attraverso l’informazione. Oggi si diffonde, infatti, l’Industrial Internet (anche detto Industry 4.0), ovvero il sottosistema dell’Internet of Things che si riferisce implementazione negli ambienti industriali con macchinari, dispositivi e software che permettono la comunicazione machine to machine (M2M, cioè fra i macchinari); human to machine (H2M, tra uomo e macchina); machine to smartphone (M2S, vale a dire tra macchina e smartphone). Così come l’IoT, di cui può essere considerato una componente, il sistema che si sviluppa con l’Industry 4.0 si basa estensivamente sulla capacità di raccogliere dati e trarre valore da questi analizzandoli: oggi si parla infatti di value of perfect information (cioè il valore dell’informazione perfetta) per indicare la capacità di ottimizzare i processi relativi alla raccolta e all’analisi dei dati, al fine di ricavare una conoscenza dei vari fenomeni osservati più immediata, approfondita e affidabile.

Con l’aumentare dei dati prodotti aumenta il loro potenziale in termini di conoscenza e, di conseguenza, aumenta il loro essere risorsa economica (ma anche sociale, politica e culturale) di primaria importanza.

Già da diversi anni- con la prima ondata della Rivoluzione Digitale, vale a dire con la prima diffusione globale di Internet- la letteratura sociologica ha introdotto la categoria temporale del Postindustriale. La principale novità di tale periodo rispetto al precedente – sulla quale si imperniano le ulteriori differenze- sarebbe proprio il fatto che il focus, prima posto sul consumo di beni e prodotti, oggi è costituito dall’informazione, la quale assurge a risorsa di sconfinata importanza e che esercita un’influenza decisiva sia nell’ambito del quotidiano che in quello dell’impresa.

Data Science: analisi e applicazioni dei Big Data

Il valore dei big data è dunque legato all’utilizzo che ne viene fatto, vale a dire alla loro analisi. I processi di analisi che fanno parte della disciplina definita come data science consentono di estrarre informazioni dalle grandi moli di dati al fine di ricavarne supporto per guidare i processi decisionali; monitorare logistica e attività; elaborare modelli di reazione a imprevisti; valutare performance e tanti altri task. È possibile distinguere diverse tipologie base di Big Data Analytics applicate all’ambito del business: descriptive analytics; predictive analytics; prescriptive analytics. La descriptive analytics (cioè l’analisi descrittiva) impiega gli strumenti analitici al fine di descrivere la situazione passata ed attuale del contesto di riferimento. Tale modello costituisce una risposta alla domanda ‘cosa è accaduto? /cosa sta accadendo?’ La predictive analytics (analisi predittiva) è un modello atto a rispondere a domande circa il futuro e a restituire previsioni sulle possibili circostanze realizzabili. Essa è dunque volta a rispondere alla domanda ‘cosa è probabile che accada?’. Infine, c’è la prescriptive analytics (analisi prescrittiva): anch’essa, come la precedente, getta uno sguardo al futuro e, nello specifico, si caratterizza per l’obiettivo di restituire soluzioni operative e strategiche sulla base delle analisi eseguite. Risponde dunque all’ipotetica domanda ‘come fare che questo accada?’. Sebbene l’analisi dei dati non sia una disciplina completamente nuova, ciò che costituisce la novità risposta al passato è la grande disponibilità dei dati, la quale permette di applicare modelli più sofisticati e avere quindi risultati molto più accurati che in passato. Il Professore Antonio Picariello, docente di Sistemi di Elaborazione delle Informazioni presso il DIETI (Dipartimento di Ingegneria Elettrica e di Tecnologie dell’Informazione) dell’Università degli Studi di Napoli Federico II, sostiene che la vastità della mole di dati oggi disponibile è destinata a cambiare il mondo della ricerca e quello dell’impresa. La quantità delle informazioni continuamente prodotte sia dall’interazione degli oggetti connessi sia sotto forma di user generated content, è un fattore determinante – anche se non l’unico- nel dare forma e caratterizzare la moderna data science. Nel caso dei big data, dunque, la maggior parte delle volte bigger significherà anche smarter poiché, secondo Picariello, i grandi dataset permetteranno agli algoritmi di lavorare meglio, tollerando gli errori e scoprendo le long tails (modelli di distribuzione diffusi) e i corner cases (casi isolati e specifici). Più dati, di contro, significa (e significherà sempre di più) anche più problemi: maggiore eterogeneità da gestire, necessità di software e algoritmi più potenti, esigenza di sistemi di storage più capienti ed efficienti e, soprattutto, urgenza di misure di protezione della privacy estese e funzionali. In questo quadro, un approccio fondamentale sembra essere quello della collaborazione fra enti e organizzazioni: il modello peer-to-peer, l’ottica collaborativa e la logica open source costituiscono infatti un’importante risorsa per le imprese e le istituzioni che mirano a ottimizzare il loro operato nell’ambito della data science, come testimonia ad esempio la diffusione della piattaforma Apache Hadoop: si tratta infatti di un ormai popolare set di software utilities open-source il cui obiettivo è quello di facilitare l’utilizzo di una rete di calcolatori per risolvere problemi che implicano vaste quantità di dati.

La vera sfida, dunque è comprendere l’utilità della mole di dati che ingloba il nostro pianeta in una rete interconnessa e, soprattutto, ottimizzare strumenti, metodi e modalità di sfruttamento. D’altronde- sostiene Picariello- ‘i dati hanno preso il posto del petrolio’ ma, a differenza del combustibile fossile estratto e sfruttato allo sfinimento nel corso dell’ultimo mezzo secolo, i dati possono essere considerati una risorsa rinnovabile e sostenibile.

Vale dunque la pena di intensificare e proseguire le ricerche sul loro utilizzo. Bisogna inoltre che divulgare l’informazione in tale ambito e, da parte delle aziende, vi è la necessità di puntare sulle competenze specifiche di quello che dall’Harvard Business Review è stato definito come ‘The Sexiest Job of 21st Century’: quello del Data Scientist.

In questo quadro, un approccio fondamentale sembra essere quello della collaborazione fra enti e organizzazioni: il modello peer-to-peer, l’ottica collaborativa e la logica open source costituiscono infatti un’importante risorsa per le imprese e le istituzioni che mirano a ottimizzare il loro operato nell’ambito della data science, come testimonia ad esempio la diffusione della piattaforma Apache Hadoop: si tratta infatti di un ormai popolare set di software utilities open-source il cui obiettivo è quello di facilitare l’utilizzo di una rete di calcolatori per risolvere problemi che implicano vaste quantità di dati.

La vera sfida, dunque è comprendere l’utilità della mole di dati che ingloba il nostro pianeta in una rete interconnessa e, soprattutto, ottimizzare strumenti, metodi e modalità di sfruttamento. D’altronde- sostiene Picariello- ‘i dati hanno preso il posto del petrolio’ ma, a differenza del combustibile fossile estratto e sfruttato allo sfinimento nel corso dell’ultimo mezzo secolo, i dati possono essere considerati una risorsa rinnovabile e sostenibile.

Vale dunque la pena di intensificare e proseguire le ricerche sul loro utilizzo. Bisogna inoltre che divulgare l’informazione in tale ambito e, da parte delle aziende, vi è la necessità di puntare sulle competenze specifiche di quello che dall’Harvard Business Review è stato definito come ‘The Sexiest Job of 21st Century’: quello del Data Scientist.