Come migliorare la misurazione delle campagne pubblicitarie ...

Errare è umano, allucinare è AI: i pericoli nascosti degli sbagli di ChatGPT

Le risposte plausibili ma sbagliate ai prompt degli utenti, che in alcuni casi possono trasformarsi in fake news

17 Giugno 2024

L’AI è ormai diventata parte integrante del nostro modo di ricercare le informazioni online. Che si tratti dei compiti degli studenti, delle email di lavoro o di ricerche scientifiche e testi di giornale, è davvero raro che almeno qualche passaggio non sia fatto sugli strumenti AI più famosi come ChatGPT, Gemini o CoPilot.

In fondo danno risposte velocissime, accurate, complete su qualsiasi argomento, da come fare la pizza in casa ai più reconditi dati storici su Galileo Galilei.

Ed è così in effetti. Almeno circa nel 95% dei casi.

Ma cosa succede in quella minima percentuale di situazioni in cui l’AI prende letteralmente Roma per toma e fornisce informazioni che nel migliore dei casi sono evidentemente errate, e nel peggiore sono perfettamente plausibili ma del tutto inventate?

Può essere un calcolo matematico errato ma riportato come corretto, la fonte di uno studio scientifico inventato, un fatto storico travisato o qualsiasi altro tipo di errore nella risposta, indiscutibile ma difficile da scorgere.

Succede che l’Intelligenza Artificiale ha avuto un’allucinazione, come si dice in termini tecnici (artificial hallucination).

Può sembrare qualcosa di divertente, un’occasionale e innocua svista anche da parte delle onnipotenti AI, che ci consola sul fatto che forse siamo ancora più intelligenti noi.

In realtà è un bug (o meglio una feature, come vedremo) che può avere pesanti ripercussioni.

E parlarne di più forse è il primo passo per arginare il problema.

LEGGI ANCHE: Netflix, PayPal, Spotify e gli altri brand che usano l’AI per il marketing

Le probabilità delle allucinazioni nell’AI

Cosa penseresti se ti dicessi che, parlando con un qualsiasi professionista di un argomento specifico del suo campo di specializzazione, quella persona potrebbe pronunciare in media quattro frasi completamente assurde ogni cento?

Immagina di andare dal tuo medico, dall’avvocato, o di leggere un articolo di giornale e sapere che questa è la percentuale di probabilità che le informazioni che stai ricevendo siano in qualche modo “allucinate”. Non sarebbe un buon punto di partenza per fidarti di quanto ti viene detto, no?

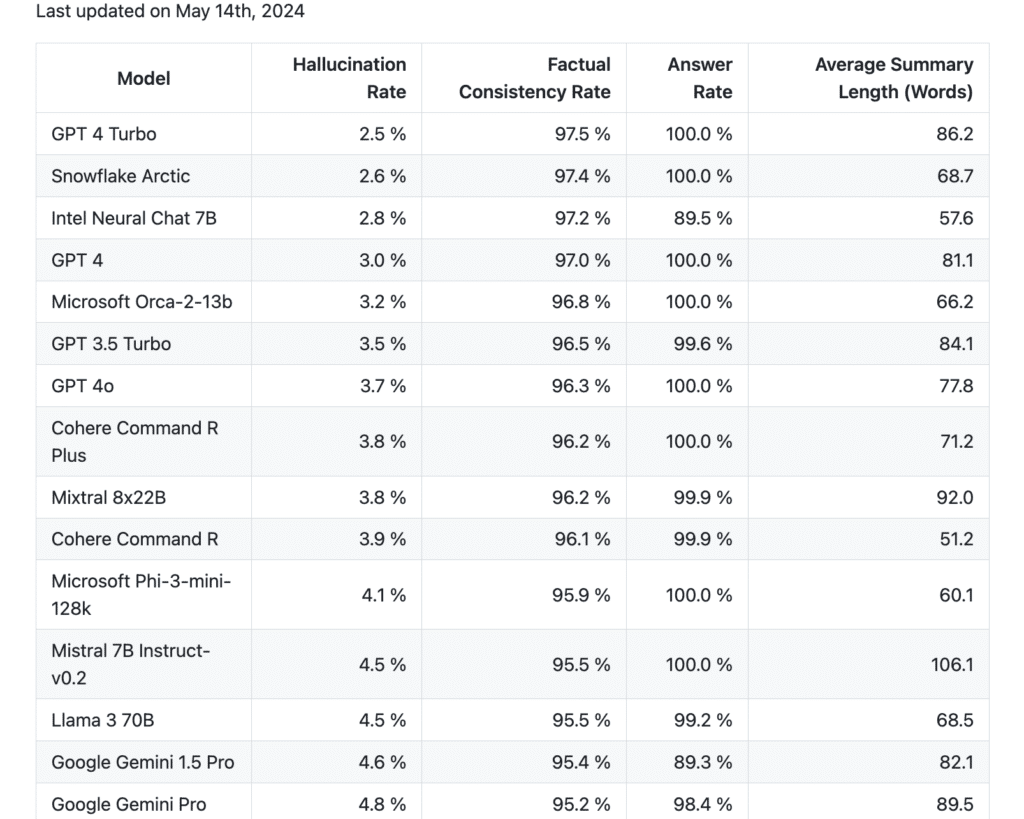

Ecco, secondo la classifica messa a punto da Vectara per valutare quanto spesso capitino questi episodi allucinatori ai LLM (Large Language Models, i modelli AI su cui si basano prodotti come ChatGPT), i risultati aggiornati a maggio 2024 variano da un minimo di 2.5% delle volte a cifre molto più alte come 22.4%.

Il vincitore è la nostra amichevole AI di quartiere, ChatGPT, con il suo modello GPT 4 Turbo che ha allucinazioni solo il 2.5% delle volte, mentre il nuovissimo arrivato GPT 4o ad esempio già arriva a un 3.7%, e Gemini di Google sfiora quasi il 5%.

La classifica si basa su un modello open-source che testa le AI in base alla loro capacità di analizzare un testo e di produrne un riassunto senza sbagliare (o inventare) nulla, il che anche secondo gli stessi ideatori non è comunque un quadro completo su cui basare questa valutazione, ma è il meglio che finora si sono inventati.

In effetti altri studi più specifici riportano dati molto meno confortanti. Ad esempio la ricerca presentata da Purdue University questo mese alla Computer-Human Interaction Conference, che ha analizzato la precisione delle risposte di ChatGPT davanti a domande pratiche di programmazione informatica, ha indicato che ben il 52% delle risposte (su 517 domande) non era corretto.

“Abbiamo constatato che il 52% delle risposte di ChatGPT contiene informazioni errate, il 77% è più prolisso delle risposte umane e il 78% di esse presenta diversi gradi di incoerenza rispetto alle risposte umane”, hanno scritto.

L’aspetto più preoccupante è che i programmatori umani intervistati dai ricercatori della Purdue University tendevano invece ad apprezzare le risposte di ChatGPT (il 35% di loro) e a credergli, non cogliendo gli errori generati dall’intelligenza artificiale (il 39% dei casi).

Complice il linguaggio educato, le risposte articolate e precise da libro di testo e la loro completezza, le allucinazioni più o meno gravi delle AI possono quindi bypassare spesso i nostri radar.

Come nell’esempio del professionista visto sopra. Anche se in realtà è solo in parte calzante.

Perché non è quanto spesso capitano il problema

Quando abbiamo a che fare con dei professionisti umani siamo ben consapevoli del fatto che sono…be’ umani.

E che quindi possono sbagliare, fraintenderci, avere degli scopi diversi dai nostri, persino mentire volontariamente. Le nostre difese sono alte, i nostri filtri mentali attivi.

Il problema delle AI invece è che abbassano tutte le nostre barriere anti-errore, convincendoci della veridicità delle loro affermazioni con un linguaggio eloquente e frasi ricche di informazioni e contesto che non danno adito a dubbi. Ci fidiamo quasi ciecamente, spesso saltando la fase di controllo incrociato che faremmo con un professionista umano (il classico “secondo parere” di un medico).

O peggio ancora, facendo cadere in errore i professionisti che ricercano ed elaborano le informazioni per lavoro (giornalisti, ricercatori, professori, avvocati, etc) e che a loro volta forniscono al proprio pubblico quella che dovrebbe essere informazione verificata, e invece è allucinata.

Il vero problema quindi non risiede tanto nella probabilità che un’allucinazione capiti, ma nel fatto che qualora succedesse l’AI fornirebbe la risposta senza senso nello stesso modo assertivo e convincente di tutte le sue risposte corrette, e che noi, abituati al fatto che abbia ragione, abbiamo minori probabilità di mettere in discussione quella risposta e quindi di scoprirne l’errore.

Infatti secondo un sondaggio somministrato dall’azienda Tidio su 974 utilizzatori di questo tipo di AI, ben il 72% si fida che l’intelligenza artificiale fornisca informazioni affidabili e veritiere, sebbene la maggior parte di loro (86%) abbia fatto esperienza delle sue allucinazioni almeno una volta.

Circa il 75% è stato ingannato e non ha riconosciuto l’errore, mentre il 33% di coloro che non le hanno mai sperimentate ritiene che sarebbe stato ingannato.

In fondo sono intelligenze artificiali, hanno studiato sopra tutto lo scibile umano, tutti ne parlano come strumenti incredibili in grado di fare al meglio tutto…come possono sbagliare?

Alla base delle allucinazioni dell’AI

Il termine “allucinazioni” ovviamente non nasce per descrivere qualcosa di artificiale, ma di molto umano: una falsa percezione della nostra mente che non si basa su uno stimolo oggettivo, facendoci vedere o sentire qualcosa che in realtà non c’è.

Ma è da qualche anno ormai che questa parola ha assunto tutto un nuovo significato in relazione alle AI, che come noi ogni tanto hanno degli episodi confusionari e rispondono o creano cose che non erano lì.

Qualcosa che ha avuto così tanta risonanza l’anno scorso nella lingua inglese da essere addirittura eletta “parola dell’anno” da Dictionary.com.

La definizione è di un’allucinazione artificiale è quando un’AI del tipo “Large Language Model” si trova a “produrre informazioni false contrarie all’intento dell’utente e presentarle come vere e reali“.

E qui infatti finisce l’analogia con l’allucinazione umana, perché se questa è semplicemente un’errata percezione, quella dell’AI è un errata comunicazione: il fatto allucinato viene presentato come vero, corretto, reale, confermato da fonti (inesistenti) e con nomi di perse coinvolte (che magari esistono, ma nella vita hanno fatto tutt’altro), magari anche corredato da aggettivi quali “ben noto” oppure “risaputo”.

LEGGI ANCHE: I pericoli dell’Intelligenza Artificiale applicata al digital advertising

Perché le intelligenze artificiali hanno allucinazioni così reali?

Non è facile identificare le motivazioni di queste risposte folli da parte dei LLM, persino gli esperti di intelligenza artificiale faticano a dare una risposta univoca.

Mancanze e contraddizioni nei dati forniti per il loro addestramento, ad esempio, possono rendere sbilanciate le capacità dell’AI su certi argomenti piuttosto che su altri (se ad esempio venisse addestrata solo con le conversazioni esistenti sui social media, avrebbe grosse difficoltà a parlare come un umano in contesti legali).

C’è inoltre un problema denominato “overfitting“, che avviene quando un modello diventa iper-sintonizzato sui propri dati di addestramento storici e questo ostacola la sua capacità di generalizzare efficacemente nuovi dati.

Un’altra sfida nello sviluppo dei modelli LLM consiste nell’assicurarsi che i testi di addestramento e i prompt siano codificati correttamente. I modelli linguistici utilizzano un processo chiamato “codifica vettoriale”, in cui i termini vengono mappati non come parole, ma come combinazioni di numeri.

Questo approccio offre diversi vantaggi rispetto al lavoro diretto con le parole, perché le parole con più significati possono avere rappresentazioni vettoriali distinte per ogni significato, riducendo la possibilità di confusione.

Ad esempio, la parola “piano” avrebbe una rappresentazione vettoriale specifica per lo strumento musicale e una totalmente diversa per il significato sinonimo di “progetto”.

Questo è alla base dell’efficacia dei LLM, ma problemi nel processo di codifica e decodifica tra testo e rappresentazioni possono portare ad allucinazioni o a risultati senza senso nel testo generato.

In generale, le allucinazioni sono manifestazioni dovute alla complessità del funzionamento delle AI e dalla confusione intrinseca dei dati con cui sono addestrate.

I Large Language Models sono sistemi basati appunto su enormi quantità di informazioni, quasi tutto lo scibile umano sotto forma di ciò che è disponibile online, ma non “ragionano” veramente su ciò che immagazzinano.

Ciò che fanno è semplicemente rielaborare questa enorme mole di informazioni per fornire una risposta quanto più sensata possibile in base all’input dell’utente, e possono avere difficoltà a distinguere tra fonti di informazione di alta e bassa qualità.

Anche voi avreste le allucinazioni se leggeste tutto ciò che che c’è su internet probabilmente.

Bug o feature?

Qualcosa a questo punto dovrebbe essere evidente: per come funzionano questi modelli così impressionanti, le cosiddette allucinazioni non sono un bug, sono una caratteristica intrinseca dell’IA generativa.

L’intero principio dei LLM si basa sulla capacità di rielaborare i contenuti appresi, senza però essere in grado di comprenderli razionalmente.

Andrej Karpathy, uno dei fondatori di OpenAI, ha twittato qualcosa di illuminante a riguardo:

“Sono sempre un po’ in difficoltà con il ‘problema dell’allucinazione’ nei LLM. Perché, in un certo senso, l’allucinazione è tutto ciò che fanno i LLM. Sono macchine che creano sogni”.

Ciò che Andrej intendeva è che attraverso i prompt diamo il via a un processo di creazione di qualcosa di nuovo (un “sogno”) basato sulla rielaborazione dei dati di addestramento del LLM, che fornisce il più delle volte un risultato utile proprio per la sua originalità.

Quando questa originalità però “straborda” oltre i limiti di ciò che è corretto, i fatti come noi li conosciamo insomma, lo etichettiamo come “allucinazione” e abbiamo un problema (soprattutto se ad avere l’allucinazione è un prodotto come ChatGPT, un assistente AI per gli umani basato sul LLM).

“All’estremo opposto, consideriamo un motore di ricerca. Il motore di ricerca prende il prompt e restituisce uno dei “documenti di addestramento” più simili che ha nel suo database, alla lettera. Si potrebbe dire che questo motore di ricerca ha un “problema di creatività”: non risponderà mai con qualcosa di nuovo.

Un LLM sogna al 100% e ha il problema dell’allucinazione. Un motore di ricerca sogna allo 0% e ha il problema della creatività“, continua il tweet.

In ultima analisi ciò che sembra un bug, in realtà è solo il LLM che fa il suo lavoro, e non è qualcosa che verrà risolto (al massimo può essere mitigato con i RAG, Retrieval Augmented Generation, in soldoni sistemi AI di fack-checking per altre AI).

Siamo noi che, utilizzando gli assistenti basati su quel modello come oracolo di Delfi a cui affidare la risposta a ogni nostra domanda, ci esponiamo al rischio che le allucinazioni si trasformino in vere e proprie fake news con ricadute a cascata, più o meno gravi.

Tante allucinazioni, alcune più pericolose di altre

Queste allucinazioni possono avvenire sotto forme molto diverse, alcune abbastanza innocue, altre molto più gravi, soprattutto se non ci fermiamo al fatto in sé ma analizziamo le implicazioni a cascata.

- Esistono le semplici contraddizioni del prompt, in cui l’AI risponde proprio Roma per toma, proponendoci idee regalo per il nostro fidanzato quando abbiamo in realtà chiesto di suggerircene per la festa della mamma: sono capitate a tutti ogni tanto (anche se avvengono sempre meno con l’avanzare dei modelli), e ci strappano un sorriso di superiorità e nulla più.

- Poi ci sono i casi di contraddizione interna nelle risposte dell’IA, in cui ciò che viene fornito è tendenzialmente logico e rilevante, ma poi qualche pezzo (soprattutto nelle risposte più lunghe) ad attenta analisi contraddice quanto detto precedentemente.

- Avvengono anche molto spesso delle allucinazioni nei calcoli, che forse sono quelle con cui possiamo più facilmente simpatizzare, perché a chi non è mai capitato di pensare che la matematica sia un po’ un’opinione? Sono quelle che più facilmente ci sfuggono, perché tendiamo a pensare all’AI come a un calcolatore e a fidarci ciecamente delle sue competenze matematiche, ma in realtà si tratta di un modello linguistico che non è stato addestrato nello specifico sulla logica matematica. Anzi è proprio uno dei suoi punti di debolezza.

- Infine, le allucinazioni più gravi: le contraddizioni di fatti, quelle risposte che presentano eventi completamente inventati come reali, personaggi esistiti come matematici quando in realtà erano degli psicologi, o attendibilissime fonti scientifiche pubblicate sulla rivista Nature, con tanto di data, ricercatori e link, che in realtà non esistono.

Insomma, siamo davanti a vere e proprie fake news, fabbricate ad arte per essere convincenti e realistiche, solo che al contrario delle fake news umane dietro a queste non c’è una volontà, semplicemente il caso.

Ma questo non le rende meno pericolose. Anzi.

Il problema di queste allucinazioni, specialmente quelle dell’ultimo tipo, è che sono quasi impossibili da scoprire a meno di non fare una verifica manuale di ogni informazione. Il che vanifica l’efficacia e il risparmio di tempo dell’aver utilizzato l’AI in primo luogo, tra l’altro.

Inoltre sono a volte talmente insospettabili da passare del tutto sotto i filtri della nostra attenzione: spesso utilizziamo ChatGPT e company non tanto per scrivere o cercare le cose più importanti della nostra vita, quelle per cui (si spera) abbiamo ancora il desiderio e lo stimolo di metterci la testa.

LEGGI ANCHE: Le 4 C per affrontare il futuro dell’AI: intervista ad Abran Maldonado, OpenAI ambassador

Piuttosto le usiamo per compiti semplici, tipo scrivere un’email in inglese per rispondere a una proposta di lavoro, in cui diamo al GPT un elenco di link a nostri articoli da citare come portfolio.

La cascata di rischi delle allucinazioni AI

Ci avviciniamo a quello che è il vero e più grave problema. La disinformazione sulla potenziale disinformazione fornita dalle AI.

E se la seconda è casuale, la prima potrebbe invece essere dolosa, perché il mercato dell’AI è talmente esplosivo e attrattivo per chi vuole venderla/insegnare a utilizzarla, che è forse “poco sexy” ricordarne i limiti.

Avvertire che sì, l’intelligenza artificiale è molto utile e molto intelligente. Ma non è infallibile, sta all’essere umano che la utilizza farlo in modo consapevole, etico e corretto.

Possiamo ragionevolmente dare per scontato che quotidianamente molti professionisti che lavorano con la ricerca e la creazione di informazioni (dai giornalisti agli avvocati, dai medici ai ricercatori, dai formatori di ogni campo a coach, psicologi, imprenditori, etc) supportino il proprio lavoro con l’AI, partecipando all’espansione del corpus informativo del web e della nostra cultura.

Quanti di questi professionisti si prendono in tempo di verificare ogni singolo elemento partorito dall’AI, prima di riutilizzarlo, modificarlo e pubblicarlo come proprio, senza partire dal presupposto che sia corretto perché ChatGPT o similare l’ha presentato come tale?

Basta una disinformazione nascosta nel mare delle informazioni corrette per scatenare un effetto a cascata, perché qualcun altro successivamente andrà a prendere quell’insieme di informazioni come corrette e le riutilizzerà, magari inserendo a sua volta qualche minima disinformazione involontaria causata da un’allucinazione artificiale, prima di pubblicare il proprio lavoro, e così via all’infinito.

Ad ogni gradino precedente di informazione dovrebbe corrispondere una verifica di veridicità, ma quanto a fondo si può andare quando invece quell’informazione è fornita da un’AI generativa che non fornisce fonti facilmente verificabili?

Valutare i rischi dell’informazione fornita dalle AI e minimizzarli nell’uso quotidiano

Ci sono campi in cui questo è un rischio accettabile (se un’azienda implementa un assistente AI basata sui LLM per fare customer service sul sito, un tasso di errore tra il 3 e il 20% può essere accettabile) è evidente che in altri fa la differenza tra la vita e la morte. Pensiamo al campo medico, della ricerca scientifica, del giornalismo, dell’informazione specialistica, finanziaria, legale, etc.

Un esempio è riportato da un articolo della rivista Nature, in cui una ricercatrice in ambito psichiatrico si è trovata a fare i conti con un’allucinazione del tipo più pericoloso, quello in cui ChatGPT inventa fonti e pubblicazioni scientifiche e le presenta come assolutamente valide.

Per fortuna il metodo scientifico dovrebbe proteggerci (almeno in teoria) da questi errori in campo scientifico, ma si può dire lo stesso di tutti gli altri?

La maggior parte delle aziende di tutti i settori utilizza già l’AI in qualche forma nelle proprie attività, e il numero è in continuo aumento. I risultati forniti dagli strumenti di Intelligenza Artificiale, se sbagliati, potrebbero causare conseguenze gravi e responsabilità legali.

Cosa fare quindi per minimizzare questi rischi, consapevoli del fatto che per quanto avanzate possano diventare questo genere di AI, è praticamente impossibile che il “problema” delle allucinazioni scompaia?

Le ultime versioni di ChatGPT per esempio sono già state addestrate per essere più “oneste” su ciò che non sanno, mitigando quindi il problema, ma come abbiamo visto le allucinazioni sono strettamente correlate al funzionamento dei modelli di linguaggio di grandi dimensioni.

Esserne consapevoli è un primo passo: elevare i nostri livelli di allerta, i nostri “filtri anti-allucinazione” umani, quando utilizziamo ChatGPT e i suoi simili, può portarci a mettere in discussione ciò che ci forniscono come assoluto e a scoprire questi piccoli, grandi errori più facilmente.

Valorizzare il nostro tempo quando cerchiamo ed elaboriamo le informazioni è un altro elemento. Ci viene detto continuamente che le AI ci rendono più produttivi, più performanti, più veloci, che fanno cose al posto nostro liberando tempo per noi, etc. Questo si verifica più su alcuni compiti che su altri, ma quando ci affidiamo a questi strumenti e li usiamo come fonti di informazioni basate su fatti reali dobbiamo rimanere consapevoli che non sono senzienti, né onnipotenti – per fortuna.

Devono essere uno strumento nelle capaci ed etiche mani umane, non il contrario.

Inoltre possiamo utilizzare strumenti specifici per compiti specifici (ad esempio, GPT addestrati in matematica se dobbiamo fare calcoli), o modificarne i parametri in base alle nostre necessità. Giocare con il parametro della Temperatura tra le impostazioni avanzate di ChatGPT e simili ci permette di controllare la quantità di “sogno” che le risposte possono includere: a temperatura più elevata corrisponde maggiore originalità nella risposta, e quindi maggiore rischio di allucinazioni.

Infine, staremo a vedere le performance dell’ultimo arrivato nella corsa all’AI generativa, Perplexity.ai: un motore di ricerca basato sull’Intelligenza Artificiale che si propone proprio di controbilanciare la creatività di questi strumenti con la necessità di essere più affidabili, addestrato per dare rilievo alle citazioni secondo lo stesso meccanismo che premia gli articoli accademici.