Meta allenta le restrizioni sulla privacy per accelerare lo sviluppo dell’AI

Meta presenta Llama 4 e sfida OpenAI

7 Aprile 2025

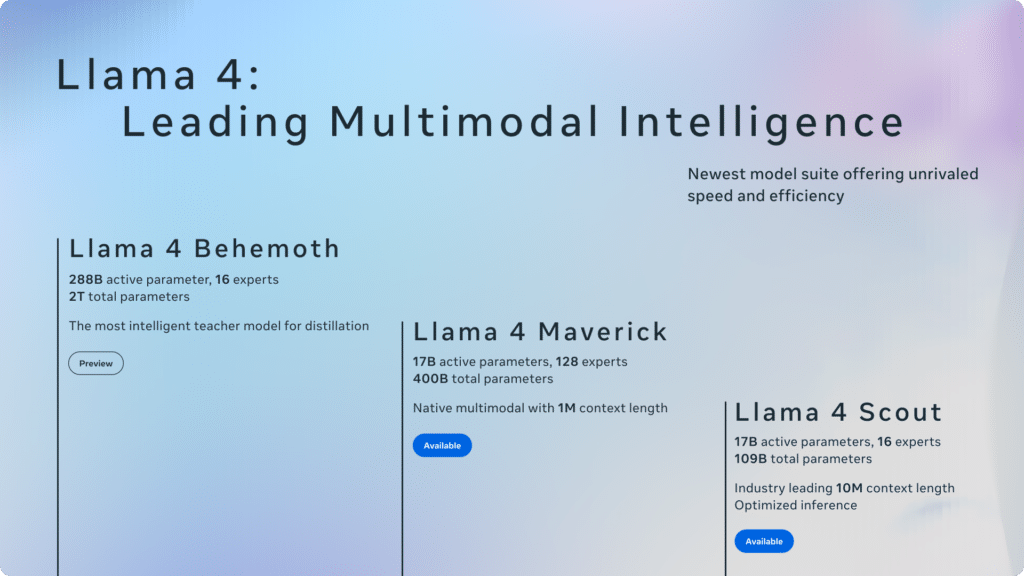

Meta ha presentato ufficialmente Llama 4, la sua nuova famiglia di modelli di intelligenza artificiale destinati a rivoluzionare l’ecosistema AI open-source.

Questi modelli alimentano il nuovo Meta AI, l’assistente virtuale già integrato su WhatsApp, Messenger e Instagram, e accessibile anche via web.

Con questo lancio, Meta alza l’asticella nel confronto Meta vs OpenAI e Meta vs Google Gemini.

Caratteristiche di Llama 4 Scout

Il primo della serie è Llama 4 Scout, un modello compatto, ma straordinariamente potente.

Funziona su una singola GPU Nvidia H100 ed è in grado di gestire una finestra di contesto da 10 milioni di token, un valore senza precedenti per modelli di queste dimensioni.

Questa caratteristica offre un vantaggio concreto per task complessi, mantenendo performance elevate su infrastrutture limitate.

Prestazioni di Llama 4 nei benchmark

Nei principali benchmark, Llama 4 Scout supera modelli come Gemma 3, Gemini 2.0 Flash-Lite e il celebre Mistral 3.1.

La sua capacità di gestire grandi volumi di dati con efficienza computazionale lo rende ideale per applicazioni aziendali e sviluppatori indipendenti.

Meta dichiara che anche Llama 4 Maverick offre prestazioni comparabili a GPT-4o, con un numero minore di parametri attivi.

Differenze tra Llama 4 Scout e Llama 4 Maverick

La gamma modelli Llama 4 include anche Maverick, una versione pensata per competere direttamente con GPT-4o di OpenAI e Gemini 2.0 Flash di Google.

Le differenze tra Llama 4 Scout e Llama 4 Maverick riguardano principalmente dimensioni, potenza di calcolo e contesto operativo: Scout è più leggero, Maverick punta alla massima versatilità in scenari avanzati.

LEGGI ANCHE: Con il nuovo modello di Runway puoi creare video con diverse inquadrature

Caratteristiche di Llama 4 Behemoth

Ancora in fase di addestramento, Llama 4 Behemoth è il modello più potente mai sviluppato da Meta: 288 miliardi di parametri attivi su un totale di 2 trilioni di parametri.

Secondo Zuckerberg, sarà il nuovo punto di riferimento globale per le performance AI, superando persino GPT-4.5 e Claude Sonnet 3.7 nei benchmark STEM.

LEGGI ANCHE: Google potrebbe lanciare una versione di Gemini per bambini

Cosa significa mixture of experts in intelligenza artificiale

Tutti i modelli Llama 4 adottano l’architettura mixture of experts (MoE): solo una parte dei parametri viene attivata per ciascun task, ottimizzando così le risorse. Questo approccio rende possibile ottenere prestazioni elevate riducendo il carico computazionale.

È uno dei motivi per cui Llama 4 può girare su una singola GPU, rendendolo accessibile anche a chi non dispone di infrastrutture avanzate.

Perché Llama 4 non è considerato davvero open source

Sebbene Meta definisca Llama 4 un modello open-source, la Open Source Initiative ha già dichiarato nel 2023 che non rispetta pienamente i criteri della definizione. Il motivo?

La licenza d’uso di Llama 4 per aziende impone restrizioni: le imprese con più di 700 milioni di utenti attivi mensili devono ottenere una licenza specifica da Meta. Una limitazione che ne compromette la reale apertura.

LEGGI ANCHE: L’agente AI Amazon fa acquisti al posto tuo. Ecco come funziona

LlamaCon: i prossimi annunci di Meta AI

Il 29 aprile si terrà la LlamaCon, la conferenza in cui Meta annuncerà i piani futuri per la sua linea AI.

È attesa l’espansione delle applicazioni di Meta AI su WhatsApp e Instagram, nuove release di modelli e, forse, aggiornamenti su Llama 4 Behemoth. Sarà anche l’occasione per valutare come Meta intende posizionarsi nel confronto con i giganti dell’AI.